怎么加密PHP代码?使用Zend Guard加密PHP代码过程

本文共 1987 字,大约阅读时间需要 6 分钟。

Zend Guard加密PHP代码过程

一、下载

zend的官网(http://www.zend.com/en/products/guard/downloads#Windows),下载 Zend Guard,,只能下载评估版的,正式版的需要付费(区别在于经评估版加密的代码,会有大概14天的时间限制,也就是说只能加密14天)

```#注意 要想使用Zend Guard加密解密必须保证自己的PHP版本是NTS(即非线程安全)版 !!!#也可以找找看有没有破解版,毕竟国内的道友们还是很强大的```

二、安装

下载Windows版的就是傻瓜式安装

三、使用

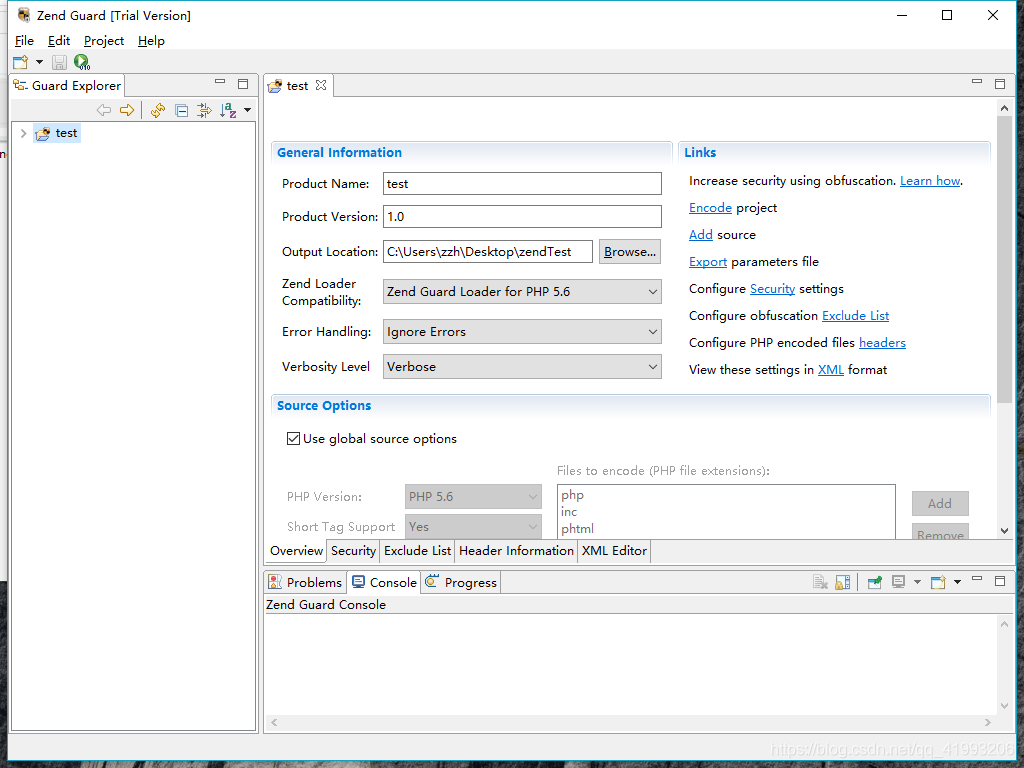

1、打开软件

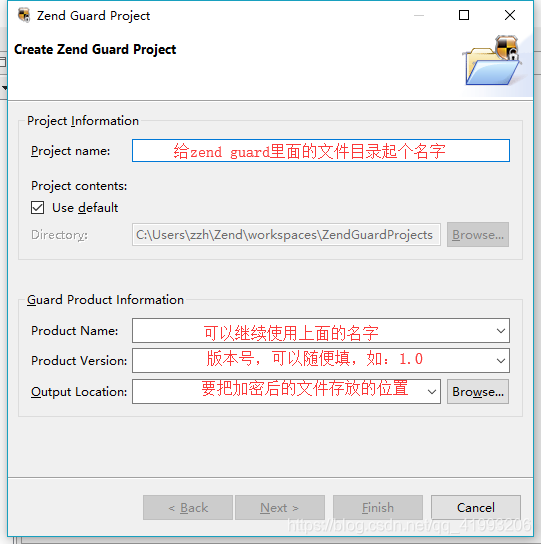

2、然后 点 File->New->Zend Guard Project,新建项目。

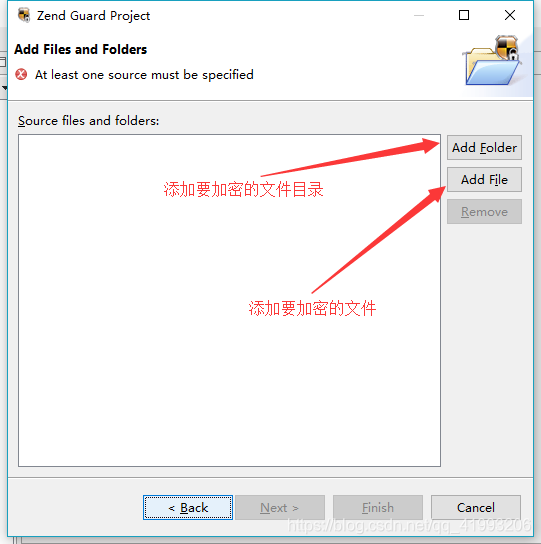

2、然后 点 File->New->Zend Guard Project,新建项目。  3、点Next

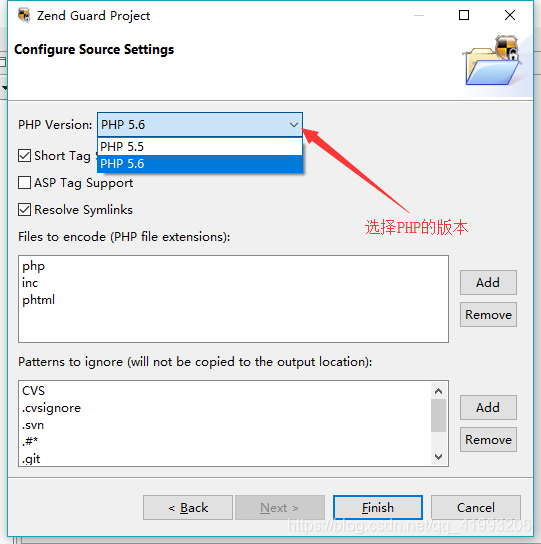

3、点Next  4、点Next

4、点Next  5、点Finish回到首页

5、点Finish回到首页  6、然后右击目录点击 Encode project,就是最基础的加密完成了

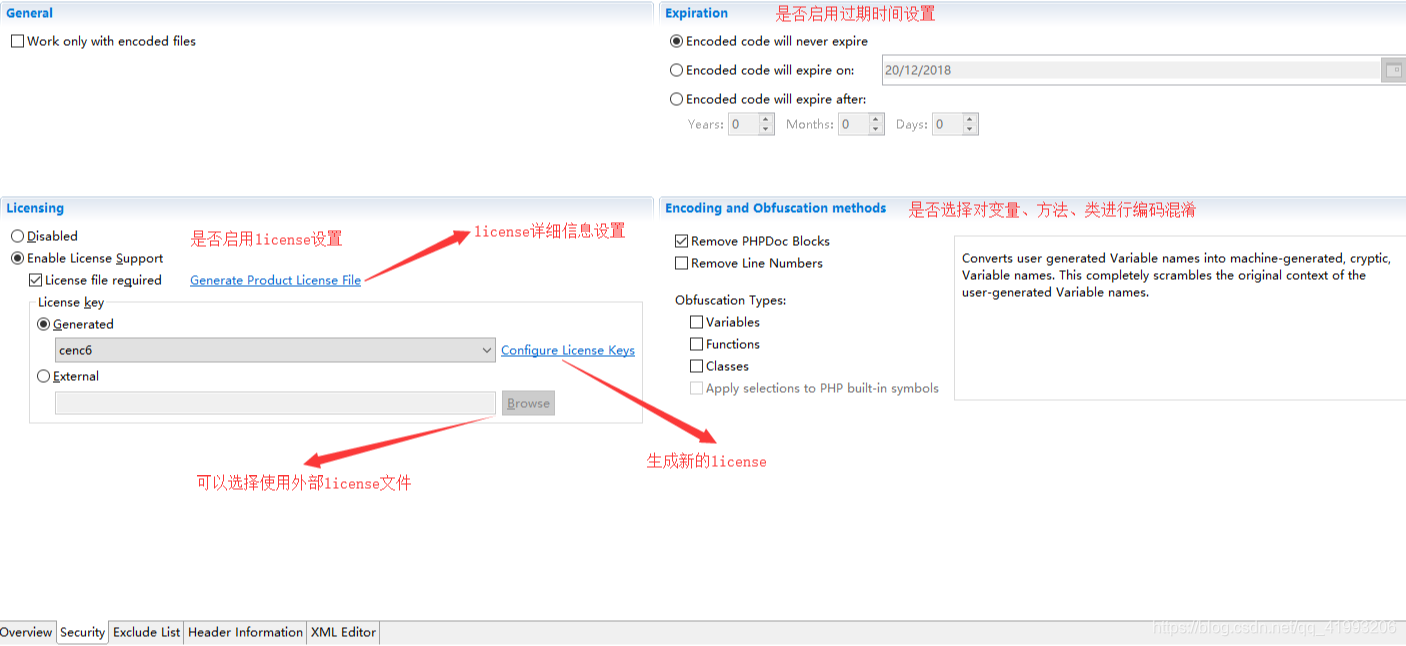

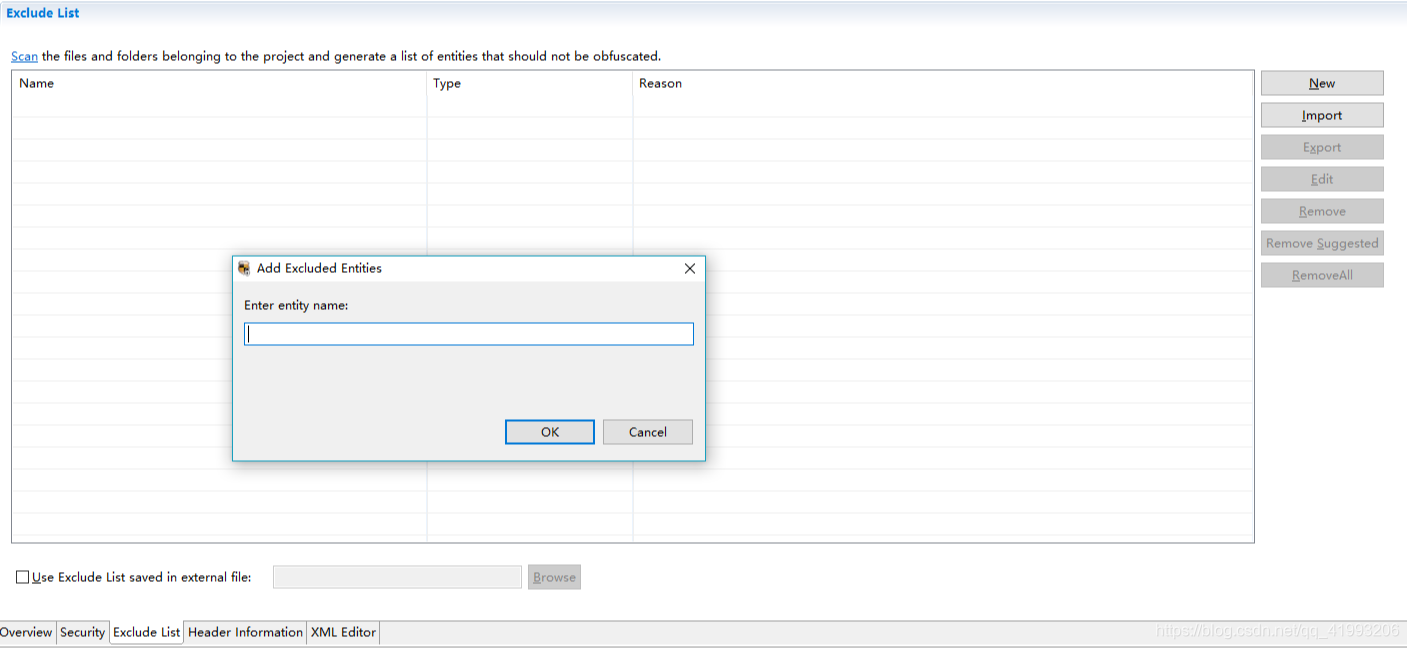

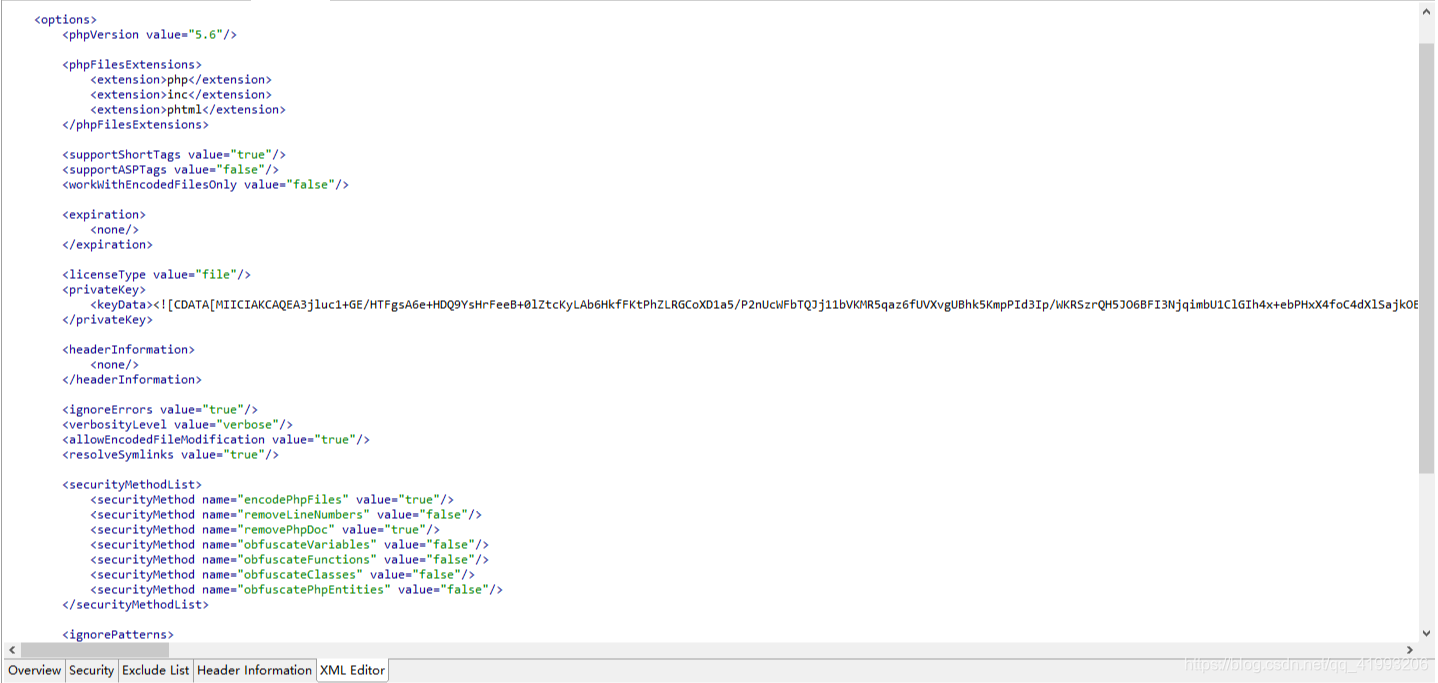

6、然后右击目录点击 Encode project,就是最基础的加密完成了 7、如果还要设置自定义的过期时间,license等就需要其它操作

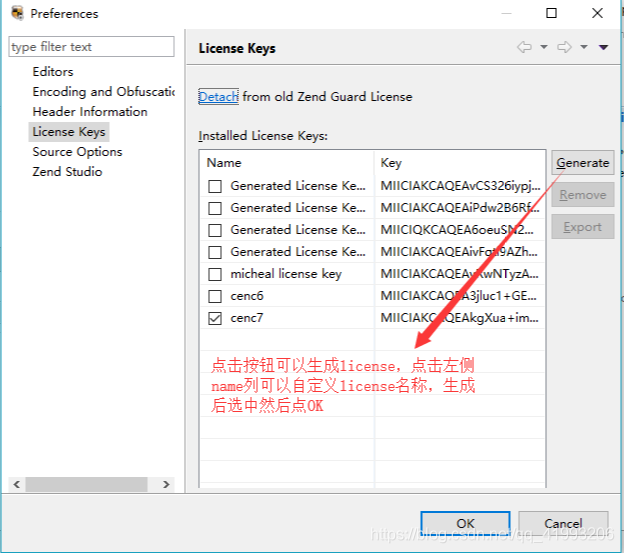

生成license:点击configure license keys,打开如下页面

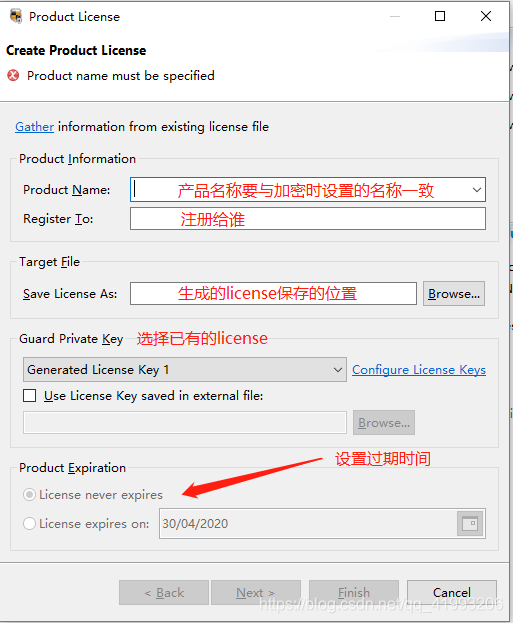

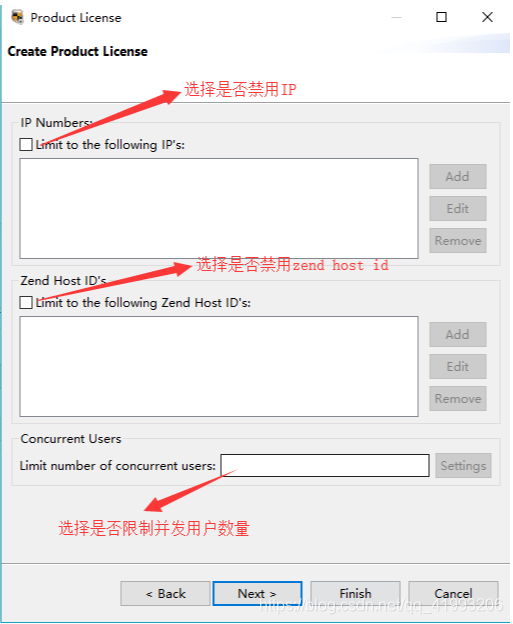

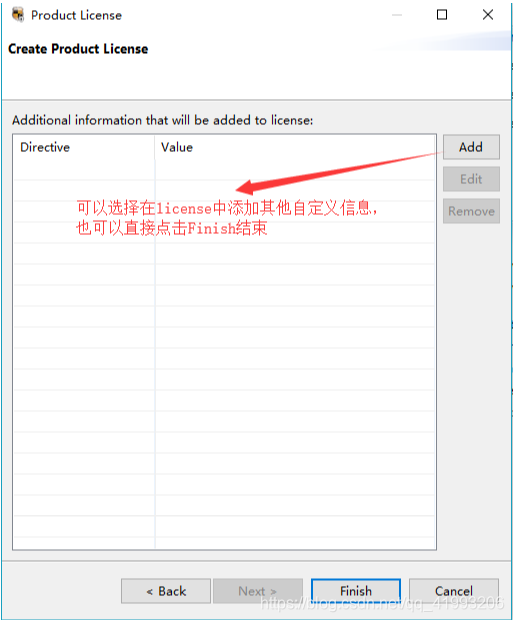

生成license文件:点击图1中的Generate product license file

生成license文件:点击图1中的Generate product license file

四、安装ZendGuardLoader扩展

1、代码加密后还需要安装ZendGuardLoader扩展,要不然会报错

Zend Guard Run-time support missing!One more more files on this web site were encoded by ZendGuard and the required run-time support is not installed orproperly configured.......

2、下载完成后把.dll文件放到php/ext目录下,然后修改php.ini,增加如下代码

[Zend.loader]zend_extension="全路径\ZendLoader.dll" #指定zend loader 扩展文件 的路径zend_extension="全路径\php_opcache.dll"(Linux版的必须拿下载的压缩包里的opcache.so去替换原来的opcache.so,要不然整个项目都会报502错误)zend_loader.enable=0 #表示是否启用zend loader,1表示启用,0表示禁用zend_loader.disable_licensing=1 #表示是否禁用许可证,1表示禁用,0表示不禁用 (由于上面我加密php文件的时候,没有设置许可证支持,故解密时,禁用许可证)zend_loader.obfuscation_level_support=3 #表示代码混淆级别zend_loader.license_path= #指定许可证文件的路径

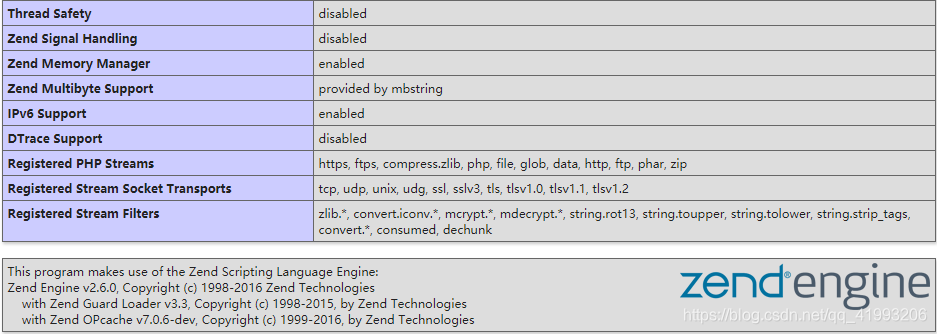

3、然后重启服务器,可以通过打印phpinfo()或者在cmd 里用 php -v命令查看是否安装

#Thread Safety 对应的值为disabled,就说明该php的版本是 NTS (非线程安全)的,否则就是TS版本的。#输出信息中,还可以看到 Zend Guard Loader v3.3 字样,说明 Zend Guard Loader 也安装成功了。

五、 遇到的问题

1. 把加密后的代码通过ftp工具放到Linux服务器中报500错误,查看日志发现 有 Unable to read **** bytes 错误 原因: 经过zend guard加密后,文件上传不完整时会出现这种情况 解决方法:把原来的代码删除,然后用XFTP的二进制模式(BINARY,即主机选Linux就行)重新上传2. 整个项目都报502错误,php, Linux日志都没有错误信息 原因:opcache与Zend Guard共享缓存,冲突了 解决方法: 可以选择注释掉opcache或者用压缩包里的opcache.so去替换原来的opcache.so

六、关于Zend Guard授权过期的问题

- 最近技术支持部门突然说远程部署的代码报错,页面也打不开。 报错内容为:PHP Fatal error: This file has expired. 报错原因为: 1. Zend软件的授权已经过期(也就是需要续费了),在这个时间段里加密的文件都是有14天有效期的,超过这个时间再运行加密的代码文件就会报上面的错误 2. 自己加密文件的时候,设置的日期过期了 解决方法:

- 简单粗暴,调整系统时间到之前的时间(如2010/01/01),相当于永远不会过期,然后重新加密文件,并覆盖掉之前的代码文件

- 重新购买软件授权,然后重新加密文件,并覆盖掉之前的代码文件

转载地址:http://vzqoz.baihongyu.com/

你可能感兴趣的文章

nginx 集群配置方式 静态文件处理

查看>>

nginx+php的搭建

查看>>

nginx+tomcat+memcached

查看>>

Nginx+Tomcat实现动静分离

查看>>

nginx+Tomcat性能监控

查看>>

nginx+uwsgi+django

查看>>

nginx+vsftp搭建图片服务器

查看>>

Nginx-http-flv-module流媒体服务器搭建+模拟推流+flv.js在前端html和Vue中播放HTTP-FLV视频流

查看>>

nginx-vts + prometheus 监控nginx

查看>>

nginx: [emerg] getpwnam(“www”) failed 错误处理方法

查看>>

nginx:Error ./configure: error: the HTTP rewrite module requires the PCRE library

查看>>

Nginx、HAProxy、LVS

查看>>

Nginx下配置codeigniter框架方法

查看>>

Nginx中使用expires指令实现配置浏览器缓存

查看>>

Nginx之二:nginx.conf简单配置(参数详解)

查看>>

Nginx代理websocket配置(解决websocket异常断开连接tcp连接不断问题)

查看>>

Nginx代理初探

查看>>

nginx代理地图服务--离线部署地图服务(地图数据篇.4)

查看>>

Nginx代理外网映射

查看>>

Nginx代理模式下 log-format 获取客户端真实IP

查看>>